Let the LLM Write the Prompts: An Intro to DSPy in Compound Al Pipelines

Extracto

I've had trouble getting my head around DSPy in the past. This half hour talk by Drew Breunig at the recent Databricks Data + AI Summit is the clearest explanation …

Resumen

Resumen Principal

El contenido destaca la importancia de DSPy como una herramienta esencial para la optimización de prompts en pipelines de IA compuestas, utilizando como ejemplo la presentación de Drew Breunig en el Databricks Data + AI Summit. Breunig, quien trabaja en Overture Maps —un proyecto que unifica datos de Puntos de Interés (POI) de múltiples proveedores, enfrentando la tarea notoriamente difícil de la conflation (deduplicación y fusión)—, ilustra cómo DSPy abordó un desafío crítico. Específicamente, utilizó un modelo local y inexpansivo, Qwen3-0.6B, para comparar 70 millones de direcciones e identificar coincidencias. DSPy, al ser utilizado con GPT-4.1 y el optimizador dspy.MIPROv2, generó un prompt de 700 tokens que elevó drásticamente la puntuación de precisión del 60.7% al 82%. Este avance subraya cómo la optimización automatizada de prompts facilita la evaluación y el cambio fluido a otros modelos, eliminando la necesidad de un tedioso proceso manual de prueba y error, y democratizando el acceso a la alta eficiencia en tareas complejas de integración de datos.

Elementos Clave

- DSPy para la Optimización de Prompts: DSPy se presenta como una solución clave para optimizar los prompts utilizados por modelos de lenguaje, especialmente modelos locales y más pequeños. Su función es refinar la forma en que los modelos interactúan con la información para mejorar su rendimiento en tareas específicas, automatizando un proceso que, de otro modo, sería manual y propenso a errores.

- Aplicación en la Conflation de POI en Overture Maps: Drew Breunig aplicó DSPy en el contexto de Overture Maps, donde la tarea crítica es la conflation de datos de POI. Esto implica la deduplicación y fusión de información de "Point Of Interest" de diversas fuentes para crear una base de datos unificada, un reto conocido en el ámbito de los sistemas de información geográfica (GIS).

- Resultados Cuantitativos de Mejora de Rendimiento: La implementación de DSPy logró una mejora sustancial. Utilizando el modelo Qwen3-0.6B, DSPy optimizó el prompt, resultando en un aumento de la puntuación de coincidencia de identidades del 60.7% al 82% para una comparación de 70 millones de direcciones. Este prompt optimizado, generado por GPT-4.1 con dspy.MIPROv2, tenía una longitud de 700 tokens.

- Ventaja Estratégica de los Pipelines de Optimización: La creación de un pipeline de optimización de prompts a través de DSPy convierte en trivial la capacidad de evaluar y cambiar entre diferentes modelos de IA. Esto elimina la necesidad de un costoso y lento proceso de optimización manual de prompts por cada nuevo modelo o tarea, ofreciendo una flexibilidad y eficiencia sin precedentes en el desarrollo y despliegue de soluciones de IA.

Análisis e Implicaciones

La capacidad de DSPy para automatizar la optimización de prompts tiene un impacto significativo, permitiendo a las organizaciones aprovechar modelos más pequeños y económicos con un rendimiento que rivaliza con el de modelos más grandes, una vez bien afinados. Esto acelera la iteración y mejora la adaptabilidad de las pipelines de IA compuestas, haciendo que la experimentación con diferentes modelos sea eficiente y escalable.

Contexto Adicional

Esta demostración proviene de una charla de Drew Breunig en el Databricks

Contenido

Let the LLM Write the Prompts: An Intro to DSPy in Compound Al Pipelines. I've had trouble getting my head around DSPy in the past. This half hour talk by Drew Breunig at the recent Databricks Data + AI Summit is the clearest explanation I've seen yet of the kinds of problems it can help solve.

Here's Drew's written version of the talk.

Drew works on Overture Maps, which combines Point Of Interest data from numerous providers to create a single unified POI database. This is an example of conflation, a notoriously difficult task in GIS where multiple datasets are deduped and merged together.

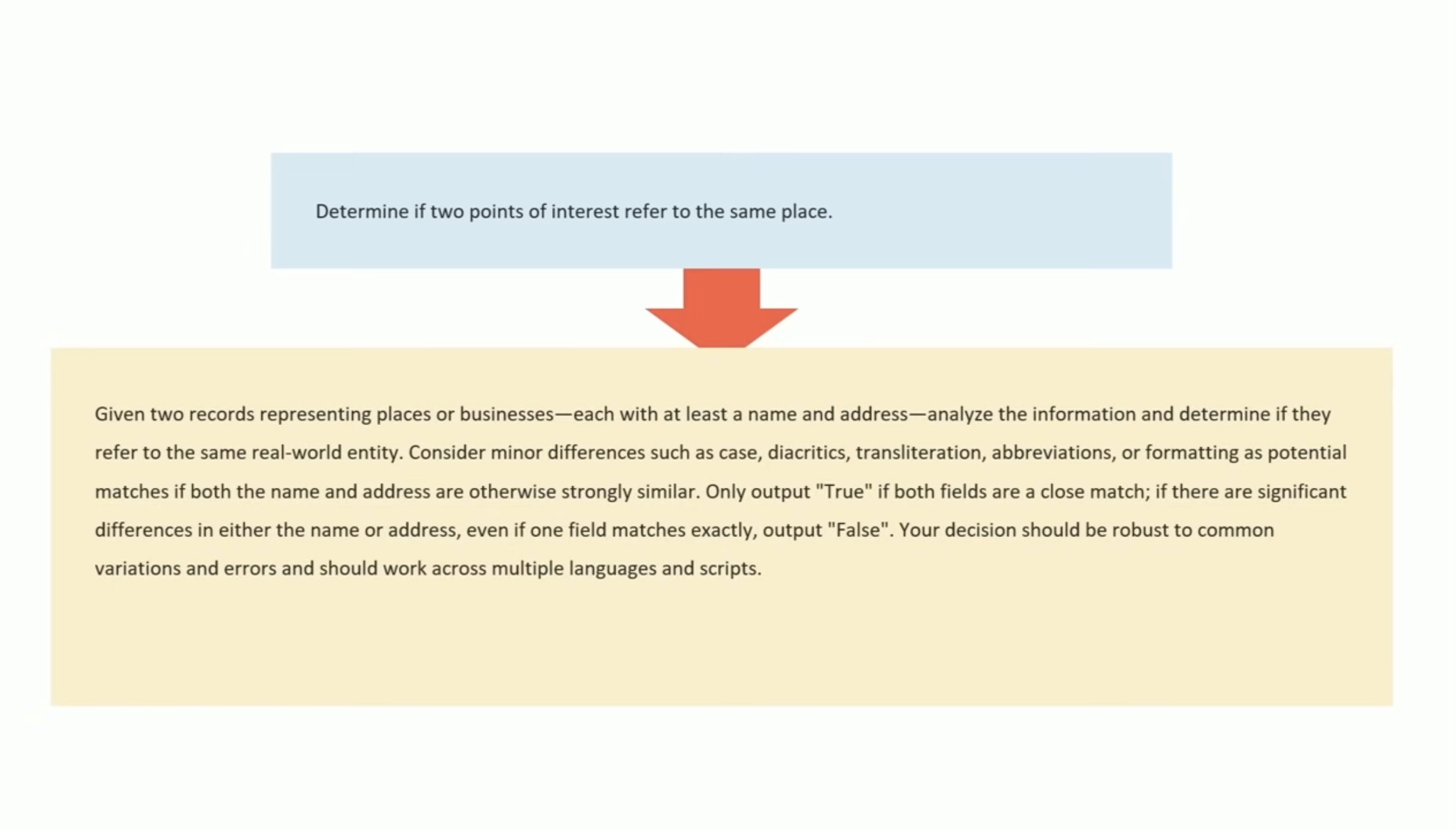

Drew uses an inexpensive local model, Qwen3-0.6B, to compare 70 million addresses and identity matches, for example between Place(address="3359 FOOTHILL BLVD", name="RESTAURANT LOS ARCOS") and Place(address="3359 FOOTHILL BLVD", name="Los Arcos Taqueria"').

DSPy's role is to optimize the prompt used for that smaller model. Drew used GPT-4.1 and the dspy.MIPROv2 optimizer, producing a 700 token prompt that increased the score from 60.7% to 82%.

Why bother? Drew points out that having a prompt optimization pipeline makes it trivial to evaluate and switch to other models if they can score higher with a custom optimized prompt - without needing to execute that trial-and-error optimization by hand.

Fuente: Simon Willison’s Weblog